事の起こり

ある日のこと。星沼会のSWATユーザーである、うーちゃんと丹羽さんが、Discord上で謎の議論をしていました。キングスレートとか赤道儀の低空モードがどうとかこうとか言っています。

キングスレート?は初めて聞く言葉です。話題になっていたのはSWATブログのこのエントリでした

上のリンクに掲載されていたグラフを、ブログ主の加曽利さんの許可を得て、ココに転載します。

40年以上前に海外で発表されたデータを元に当時の天文ガイド誌が記事にしたもののトレースです。その肝心の元記事が見つからず、正確な見方がよくわかりませんが、…(SWATブログより引用)

とのことですが、加曽利さんによれば、これは大気差の影響を考慮した赤道儀の追尾速度を表すグラフなのだろうとのこと。つまりこのグラフがあれば、撮影する天体の時角と赤緯から、各瞬間での赤道儀の最適な追尾速度をはじき出せるわけです。

ちなみに、うーちゃんと丹羽さんが話していたキングスレートの86190秒とは、多くの天体の撮影に対して平均的に、恒星時(86164秒)*1よりも妥当と言える追尾速度を表していると思われます。

上のグラフの正式名称が知りたいところですが、分かりません。このエントリーでは「追尾速度図」と呼ぶことにしましょう。それにしても、40年以上前の謎のグラフ...、なんだかロマンがあるではないですか。俄然興味が湧いてきました。

以下の概要:

結論から申しますと、上のグラフには一部間違いがあることが分かりました。そのために解釈にも混乱が生じていたようです。専門家の沖田博文さんと議論していただき、グラフを修正して、その解釈についても確認することが出来ましたので、報告します。またSWATブログでもこの結果についての記事を加曽利さんが書いてくださいました。

大気差とは

星の光が地球の大気に入ると、レンズのようにその進路がわずかに曲がります。それによって我々が観測する星の位置は、実際の方向よりも角度Rだけ天頂方向にズレて見えます。この角度Rのことを大気差と言います。

大気差Rの大きさは角度で表すことが出来ますが、その値は気圧や気温、大気の状態などによって変化するので正確に定めることはできません。しかし詳細な測定から、観測する天体の高度hとRの関係を表す近似式が知られています。それによれば

であり、Aは地上1気圧0℃の条件で60.0615秒角になります*2。次のグラフは上の式をプロットしたものです

このように大気差は天体の高度が上がるほどにその影響が小さくなります。ただしこの式は、h<15°あたりで精度が落ちるので注意が必要です。

たとえば、h=60°あたりで30秒角ですので、135mmレンズをASI2600MCにつけて撮影した場合、5pxほどのズレとなります。

大気差があると星が動く速度が変わる(直感的説明)

このような大気差が存在すると、見かけの天体の動きが遅くなったり、速くなったりします。下の図はそれを直感的に説明したものです

左の図は、南中前後の天体の1時間の動きを表しています。実際の星は東から西へ約15°動きます。しかし大気差によって、天体は天頂方向に一定角度浮かび上がって見えていますので、図から分かるように、見かけの星の1時間の動きは15°よりも小さくなります。よって、この場合は動きが遅くなります。

ほとんどの場合、大気差によって見かけの天体の運動は遅くなります。しかし興味深いことに、天体が北極星の下側を回る場合のみ反対のことが起こります。

右の図は北の空での天体の1時間の動きを表しています。大気差によって天体が浮かび上がると、見かけの星の1時間の動きは15°よりも大きくなります。よって、この場合は動きが速くなります。

うえの追尾速度図で言えば、天体の見かけの動きが遅くなる場合は、縦軸の値が恒星時よりも長くなり、また見かけの動きが速くなる場合は、縦軸の値が恒星時よりも短くなります。

修正版「追尾速度図」

上の直感的説明を踏まえて、SWATブログに掲載された追尾速度図を見てみますと、赤緯が+55°と+80°の曲線の振る舞いが奇妙であることに気づきます。グラフは北緯40°のデータですので、この2本の曲線は、北の空で地平の下に沈まない天体を示していますが、その場合、追尾速度が恒星時より短くなるのは、時角12h付近のみであるはずです。しかしグラフでは、0hでも追尾速度が恒星時より短くなっています。

これを理解するために、ノート「導入エラーの定量的評価」を公開されている沖田博文さんに不躾にも連絡を取り、教えてもらいました。

https://www.astr.tohoku.ac.jp/~h-okita/research/airt40/pointing/pointing_error.pdf

巨大自作ドブソニアンによる眼視スケッチで有名な沖田さんです

沖田さんは数日間にわたって、理解が遅い私との議論にトコトン付き合ってくれました。本当にありがとうございました。どさくさに紛れて、「いつか、自作のドブソニアンで星を見せてくださいー」って約束までしちゃいました。

おっと話がそれました。

上のノートには、大気差の時角方向成分を与える式が計算されていて、その変化率から極軸が一回転するのに要する時間を計算できます。その値を時角についてプロットすることで、上記の「謎のグラフ」に対応する曲線が得られることがわかりました。

その結果、SWATブログに掲載のオリジナルのグラフは、やっぱり子午線付近の値が間違っているだろうと結論しました。結果として得られた修正版の「追尾速度図」はこうなります。

ででん!

このグラフは、上の(1)式で表される大気差をRをもとに純粋に数学的な計算を行い、プロットしたものです(計算は沖田さんがやってくれました)。我々に勘違いが無ければ、これが正しい追尾速度図になるはずです。

観測地点を北緯40°として、赤緯-40°から+80°の曲線を10°刻みでプロットしました。ただし赤緯50°の曲線は、北の空で天体が地表に接するために除外しています。横軸が追尾する天体の時角で0hが子午線を表しています。縦軸はその局所的な移動速度から算出した極軸1回転に要する時間です。例えば赤緯+40°(黄の実線)の天体が時角6hの位置にあるときの移動速度から、天体は86250秒で極軸を一周することになります。

このグラフから分かることを箇条書きにしておきます。

- 追尾速度が恒星時を下回るのは、赤緯+60°以上、時角12h付近のみである。

- (興味深いことに)天頂付近でも大気差の影響はあり、追尾速度は恒星時よりも遅い。

- キングスレートは、赤緯0℃から+40°、時角-3hから+3hの広い範囲にわたって、とても妥当な追尾速度になっている。

- SWATブログに示されていた「低空モード」86230秒は、赤緯-25°付近の天体を追尾するにあたっては、やはり妥当である。

天頂でも星の移動が遅くなる理由(20240717 追記)

天頂では大気差 R がゼロになるにもかかわらず、追尾速度は恒星時よりも遅くなります。その理由は、高校の物理で勉強するスネルの法則を使って説明することが出来ます。

下の図をご覧ください。観測する星が南中直前の位置にあるとします。その大気差を考慮した「見かけの星」の位置が天頂から小さな角度 β だけ手前にあったとしましょう。「実際の星」が角度 α にあるとすると、スネルの法則から

です(ここで n は大気の屈折率で、15℃ 1気圧でおよそn=1.0003です)。

さて、天頂では大気差がゼロですから、上の図の状態から一定時間が経過したのち、「見かけの星」と「実際の星」は同時に天頂に到達するはずです。よって、「見かけの星」は「実際の星」よりも だけ遅く動いていることになります。

恒星時とは「実際の星」が極軸を一周するのに要する時間のことでした。「見かけの星」が上の図の瞬間での移動速度を保って極軸を一周として、それに要する時間は恒星時の n 倍になります。ところでキングスレートの値を思い出すと、恒星時との比が

86190/86162=1.0003

となって、なんと大気の屈折率にピッタリ一致します。つまり分かってみれば単純なことですが、キングスレートとはスネルの法則の現われに過ぎなかったのでした。

大気差が追尾速度に与える影響(ガチ計算)

上のグラフを得るための計算についても書いておこうと思いますが、ここで体力が尽きました。

一言注意しておきますと、上の沖田さんのノートでは、ある一つの式が間違っていました。今回の私との議論で、沖田さんがそれに気づき、間違いを修正して得られたのが上のグラフです。

なので修正版の計算を記録しておこうと思います。記事が出来上がったら以下にリンクを貼りますので、お待ちを(2024年7月16日)

*1:恒星時:大気差が無い場合に天体が極軸を一周するのに要する時間

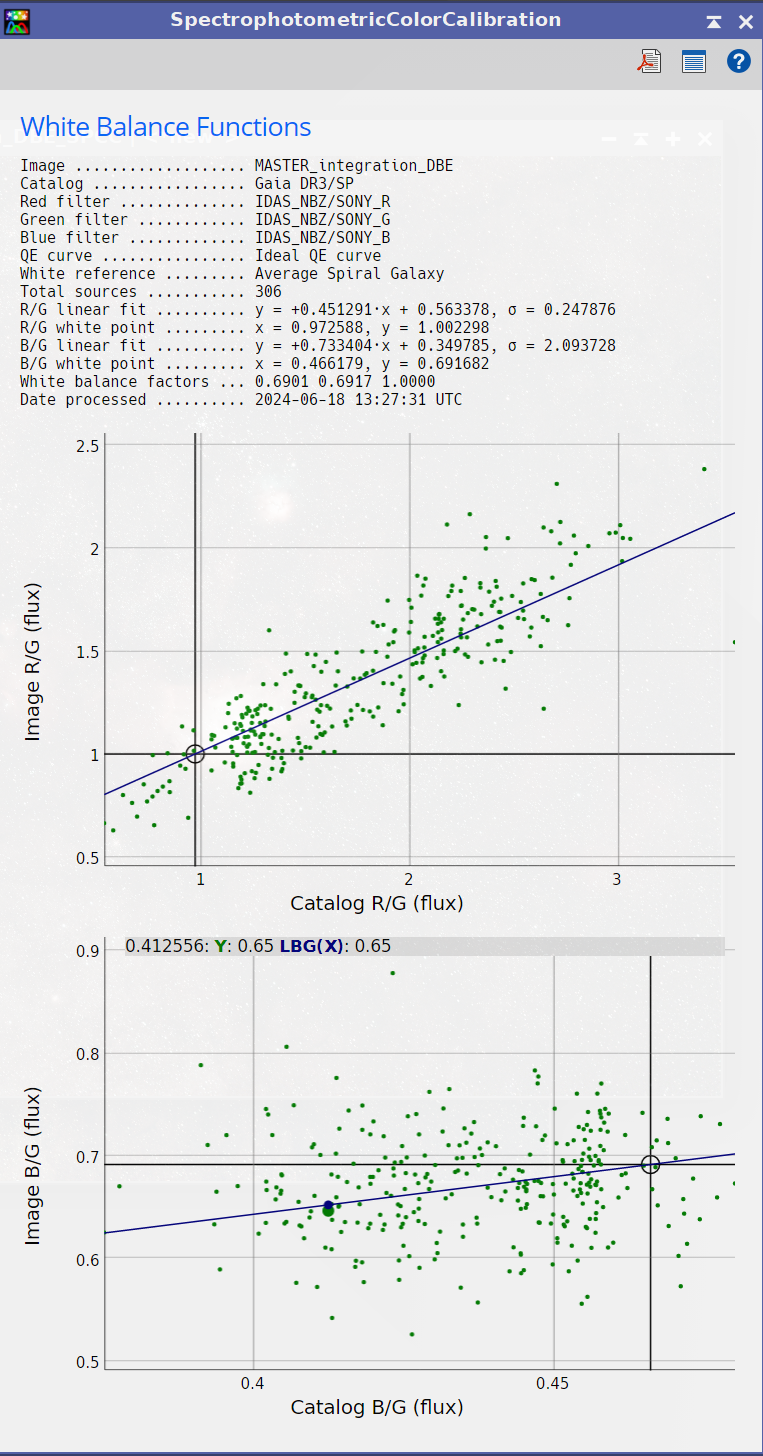

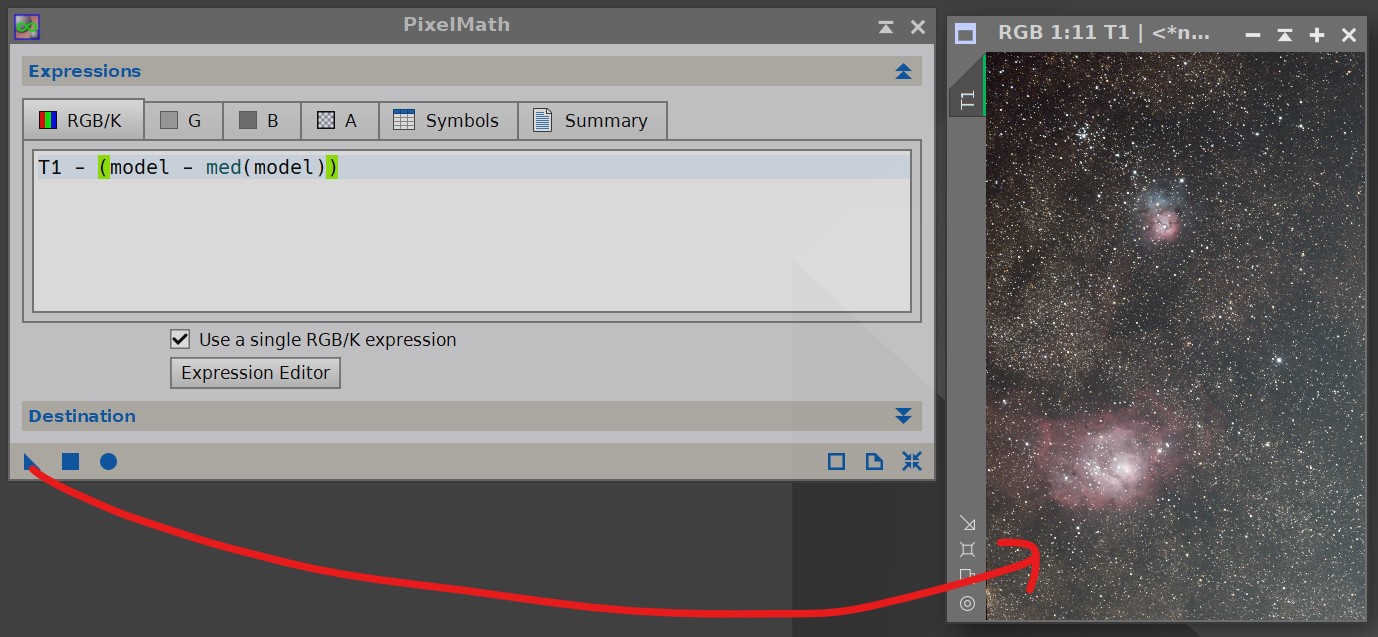

そうしたら、左下の右から2番目のアイコンをクリックします。Filter nameとfilter channelを入力する欄が出現するので

そうしたら、左下の右から2番目のアイコンをクリックします。Filter nameとfilter channelを入力する欄が出現するので